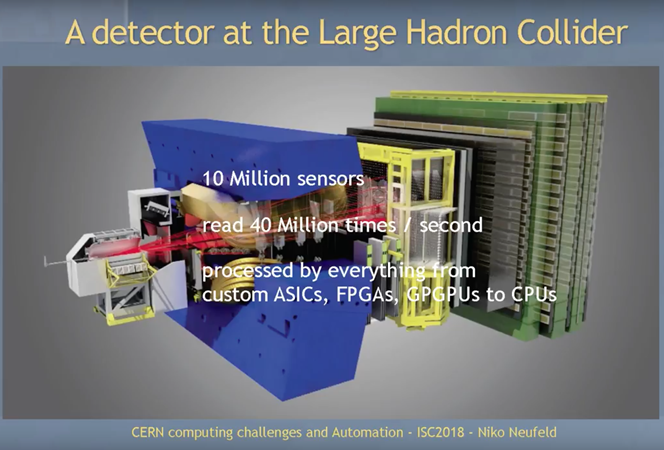

Niko Neufeld, gestionnaire adjoint de projets au CERN, donne la mesure des défis IT actuels et précise le volume de données à traiter à la frontière franco-suisse, au Laboratoire européen pour la physique des particules.

« Le CERN accumule, annuellement, plus de 20 Peta-octets de données. Au-delà de 2020, les mises à niveau de l’accélérateur LHCb vont générer des multiples de ce volume chaque année, qui devront être stockés et traités. En effet, plus de 7 millions de capteurs seront actifs toutes les 25 nano-secondes pour étudier les collisions de particules. Dans dix ans, le taux de transfert de données nécessaire dépassera les 500 Tera-bits par seconde, contre 10 Tbps en 2018 ».

Le nouveau datacenter haute densité hébergera deux clusters interconnectés, aux caractéristiques distinctes. Le premier est conçu pour les Entrées/Sorties, les données en provenance d’environ 10 000 fibres optiques transitant via des cartes PCIe à base de FPGA. Le second cluster est conçu pour les traitements CPU ; il occupera jusqu’à 4000 serveurs Xeon multi-cœur, double socket.

Au fil des expériences et des simulations des chercheurs, de nouvelles exigences techniques viennent s’ajouter à celles-ci.

Calculs hautes performances

Quel centre de données le CERN Openlab doit-il bâtir pour les prochaines décennies devant percer de nombreux mystères de la physique des particules, au-dessus de l’anneau de 27 km parcourant, sous-terre, une partie du pays de Gex (Ain) et du canton de Genève (Suisse) ?

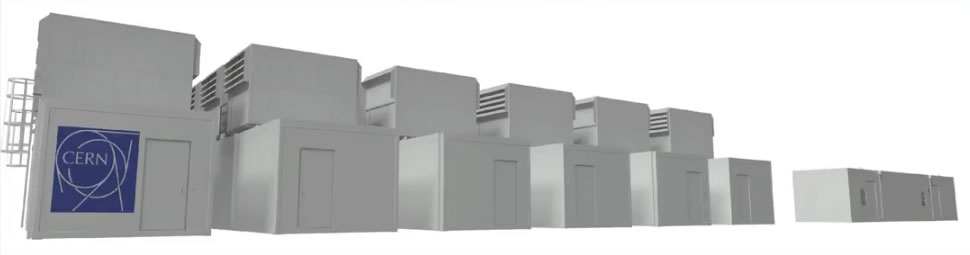

Suite à un appel d’offre, deux premiers modules ont été retenus suivant le concept d’abris conteneurisés. Disposés à proximité des sources de données, les modèles Safe-Eco proviennent de la société Automation basée à Halle, en Belgique.

ALICE (A Large Ion Collider Experiment) O2 – le nouveau système online-offline du détecteur d’ions lourds installé sur l’anneau du grand collisionneur de hadrons (LHC) – bénéficiera des deux premiers modules de 1 MW chacun, dès cet automne 2018. L’accélérateur LHCb exige également 2 MW de puissance informatique répartis sur deux autres modules d’ici à la fin novembre. Et trois livraisons de modules supplémentaires sont déjà planifiées pour 2019. En tout, dix abris-conteneurs informatiques sont prévus pour un contrat total de 10 millions d’euros.

Automation et Stulz associés dans chaque module

L’indice d’efficacité énergétique PUE (Power Usage Effectiveness) ne dépassera pas 1.1, le site bénéficiant du climat frais du Jura. En outre, les équipements sont plus tolérants à l’élévation des températures.

« Les serveurs de nouvelle génération fonctionnent correctement jusqu’à une température de 45 degrés celsius. On sera plus proche des 27 à 30 degrés au maximum », précise Jurgen Caeyman, Chief Commercial Officer d’Automation.

Conçus via un partenariat entre Automation et Stulz, les modules du CERN sont refroidis suivant le principe de froid adiabatique indirect, une solution économique pour rafraichir les racks, sans compresseur, via un simple échangeur air/air.

L’approche modulaire réunit plusieurs avantages, dont une mise en œuvre rapide, un déplacement et un entretien simplifiés.

« Nous ventilons directement au-dessus des couloirs systèmes, sans gaine à installer pour guider l’air. L’entretien se limite à changer quelques filtres et, après dix ans, les ventilateurs et roulements. Le datacenter modulaire forme un choix économique et durable », confirme Jurgen Caeyman.