Talend veut aider les entreprises à devenir ‘data-driven’, c’est à dire à gagner en réactivité en plaçant la donnée numérique au cœur du pilotage de leurs activités.

Avec la récente mise à jour de Talend Data Fabric (Spring’18), l’éditeur facilite le travail collaboratif entre responsables métiers, data scientists et informaticiens. Il apporte des intégrations simples et rapides de données cloud, en respectant les besoins de gouvernance.

« Il s’agit de raccourcir les délais, d’éviter le travail séquentiel. C’est un préalable nécessaire pour disposer de données de confiance. Il faut bien comprendre d’où elles viennent, qu’est-ce qui les met en qualité, et les rend catalogables », pointe François Méro, General Manager et Senior Vice-President chargé des ventes EMEA de Talend.

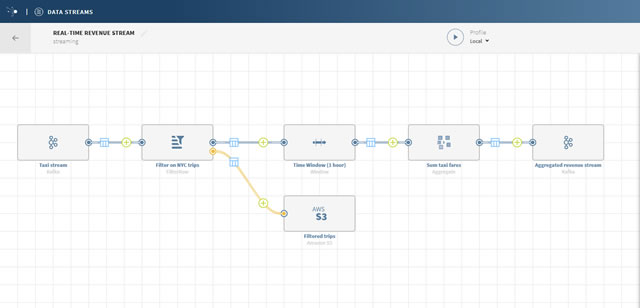

Data Stream exploite le projet Beam d’Apache

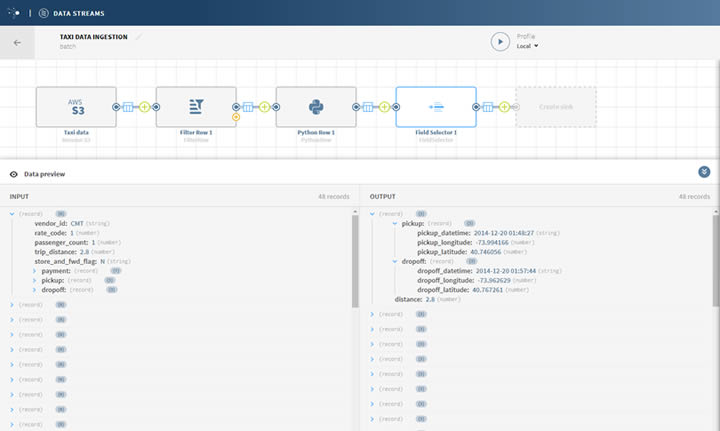

Au-delà des données structurées et non structurées, l’entreprise cherche à manipuler les données en streaming, sans stock à déplacer et produites en temps réel. Ce sont des logs de machines outils ou des flux de réseaux sociaux par exemple. Cette nature exige de lire et de transformer la data au fil de l’eau. C’est l’objectif de Data Streams, disponible sur la place de marché Amazon, gratuitement et accessible depuis un simple browser web. Ce programme exploite l’application Apache Beam, un co-développement mené avec Google visant à exécuter des pipelines de traitements de données, en batch comme en streaming.

Au-delà des données structurées et non structurées, l’entreprise cherche à manipuler les données en streaming, sans stock à déplacer et produites en temps réel. Ce sont des logs de machines outils ou des flux de réseaux sociaux par exemple. Cette nature exige de lire et de transformer la data au fil de l’eau. C’est l’objectif de Data Streams, disponible sur la place de marché Amazon, gratuitement et accessible depuis un simple browser web. Ce programme exploite l’application Apache Beam, un co-développement mené avec Google visant à exécuter des pipelines de traitements de données, en batch comme en streaming.

« En quelques minutes et sans installation – via une instance Amazon – l’application digère des flux complexes en streaming. Tandis que le flux se déroule, on voit en temps réel l’impact sur la structure des données servant à alimenter un data lake, ou des outils analytiques destinés à prendre des actions instantanées. C’est une grande avancée pour reprendre le contrôle d’un flux de données », estime le manager.

Une version cloud privé en préparation

Une version Enterprise de Data Streams est prévue pour l’automne, qui sera utilisable en cloud privé.

« Le principal frein au travail sur la donnée est sa mise en qualité. Si on doit passer 80% du temps pour la mettre en forme afin de l’utiliser, il ne reste que 20% pour faire le travail. Nous proposons de réduire la première étape, où que la donnée réside et même dans le cloud, pour en tirer profit. Cela permet, par exemple, de mieux connaître ses clients, de les comprendre et de les fidéliser dans la durée », explique-t’il.

Cette stratégie d’analyse s’appuyant sur des données récentes, via les réseaux sociaux notamment, permettrait de passer du prédictif au prescriptif. « Grâce aux technologies de machine learning et à l’automatisation, on peut trouver de vrais gains dans les données. Deux domaines d’excellence opérationnelle couvrent les applications industrielles et la supply chain, le tout dans un cycle de temps raccourci », illustre-t’il.

Mieux comprendre ses clients

L’enjeu de la connaissance du client consiste à disposer de données fiables sur son comportement, accessibles au bon endroit. Talend aide à s’approcher des actions et des réactions, transmises par les clients en temps réel, pour fournir des analyses à une famille étendue de professionnels, en self-service.

Tous les secteurs d’activités sont concernés confirme le manager, avant de mentionner en particulier la distribution, la banque et la santé très sensibles à l’immédiateté.

D’autres usages sont poussés par les besoins de gouvernance : « pour entrer en conformité avec le règlement RGPD et éviter des fuites de données, il faut être en mesure de contrôler qui fait quoi sur quelles données, faute de quoi les risques augmentent sur la réputation de l’organisation. »

Des partenaires cloud incontournables

Depuis deux ans, Talend affiche davantage de partenariats technologiques avec les géants du cloud (AWS, Google et Microsoft), avec les distributions hadoop ou encore avec Snowflake pour simplifier l’intégration, le stockage et l’analyse des données dans le cloud.

Depuis deux ans, Talend affiche davantage de partenariats technologiques avec les géants du cloud (AWS, Google et Microsoft), avec les distributions hadoop ou encore avec Snowflake pour simplifier l’intégration, le stockage et l’analyse des données dans le cloud.

« Tracer les déplacements de données, identifier clairement la source et la cible, et connaître ce qui arrive aux données entre temps, faire une cartographie des données et lire les méta-data par lesquels elles passent. Tout cela fait partie de notre roadmap. On s’appuie sur des standards de fait et sur des codes open source en sécurité », précise François Méro.